Garbage Collection, TRIM, Write Amplification, Overprovisioning

En SSD har många fördelar jämfört med traditionell magnetisk lagring. Tyvärr finns det även en del nackdelar. De flesta av dessa nackdelar har med hur NAND-flash är uppbyggt att göra. Man kan inte fixa det utan att byta ut NAND-flash mot något helt annat. Det finns flera nyare minnestyper som är på väg. Men tills dessa kan tillverkas tillräckligt billigt och i tillräckligt stora kvantiterer, så är vi fast med NAND.

Write Amplification

Det kanske största problemet med NAND är att det går bara att skriva, radera och skriva på nytt, ett begränsat antal gånger innan det helt slutar fungera. Vad som är värre är att ju finare tillverkningsteknik man använder för att tillverka minnet, desto färre skrivcyklar klarar minnet av. Detta har med fysikens lagar att göra och inget som går att rå på.

Ett NAND-flash är uppbyggt av miljontals celler. Dessa lagrar en, två eller tre bitar med data (SLC, MLC och TLC). Dessa celler är uppbyggda i ”sidor” eller ”pages”. På moderna NAND-flash så är dessa sidor ofta 8 kilobyte stora, men även 4 kilobyte är vanligt och i framtiden kommer nog detta att öka till 16 kilobyte. Sidorna är sedan ihopklumpade till ”block”. Det vanligaste är att man har 128 stycken sidor i varje block, vilket gör att ett block blir 1 megabyte stor.

Ett annat problem med NAND-flash är att man inte kan skriva över data som redan ligger lagrad. Man måste först radera datan innan man kan skriva nytt. Man kan skriva data en sida i taget men tyvärr bara radera ett block i taget. Det betyder att om du ska radera ett halvt block och skriva om med ny data, så måste informationen som ska sparas, först skrivas till ett annat block. Sedan raderas hela blocket, och den information som sparades undan, skrivs tillbaka tillsammans med den nya informationen som ska skrivas. Detta sker hela tiden och är den största orsaken till varför SSD:er tappar prestanda över tiden.

Förutom att prestandan blir sämre så innebär detta också att även om du bara ska skriva 10 kilobyte data så kan den totala mängden data som skrivits till minneskretsarna bli så mycket som 90-150 kilobyte i sämsta fall. Fenomenet kallas för Write Amplification. Värden på WA är alltså den data som operativsystemet skriver till enheten, delat med hur mycket data som faktiskt skrivs till enhetens NAND. Det säger sig självt att hög WA inte är bra för enhetens livslängd.

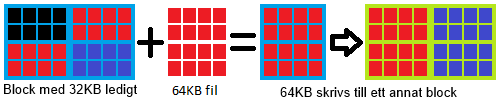

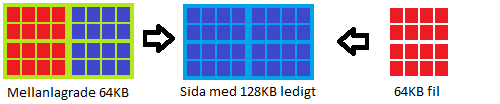

Innan vi går vidare så måste undertecknad bara be om ursäkt för mina begränsade kunskaper i MS Paint. För att enklare illustrera hur WA uppstår (i teorin) så tänker vi oss att vi har ett block med 128 kilobyte i en SSD. Blocket består, i det här fallet, av 32 stycken sidor på 4 kilobyte vardera. De minneschip som tillverkas idag har ofta sidor på 8 kilobyte men vi valde att använda 4 kilobyte i det här exemplet för det är lättare att hålla reda på. Vi skriver då 3 stycken filer på vardera 32 kilobyte. Dessa skrivs till vårt block på 128 kilobyte och då får vi 32 kilobyte ledigt.

Om vi då vill lägga in ytterligare en fil på 64 kilobyte till samma block, så får den inte plats. Därför tar vi bort en av filerna för att den nya ska få plats. Datan kan dock inte raderas, men flaggas som ogiltig.

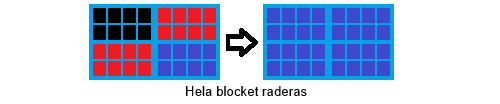

Eftersom data endast kan raderas i hela block så måste vårt block, med en massa data, tömmas. Men innan det så måste de 64 kilobyte som vi vill spara lagras någon annanstans.

Nu när all data har flyttats så kan vi lugnt radera hela sidan.

Tillslut så kan vi skriva tillbaka de gamla filerna på totalt 64 kilobyte och den nya filen vi ville skriva på 64 kilobyte. Först nu har vi fått det resultat vi ville.

Om vi då tänker efter vad som just hände. I operativsystemet har vi sagt åt SSD:n att skriva totalt 160 kilobyte. Men i SSD:n så har enheten i själva verket skrivit 32+32+32+64+128 = 288 kilobyte. Vi har därför fått en Write Amplification på 1,8. Observera att i praktiken så går det inte riktigt till så här. Kontrollern sprider nämligen ut data över alla tillgängliga block (så kallat wear leveling). Det uppstår generellt inte med sekventiell data då denna oftast kan skrivas direkt till tomma block. Hög WA inträffar för det mesta med väldigt små skrivningar och små filer som ständigt måste flyttas runt mellan olika block och olika minneschip. Förutom att WA sänker livslängden på din SSD så det sänker också prestandan. Alla dessa extra skrivningar tar tid, vilket ger längre väntetider mellan skrivningar (latency) och därmed sämre prestanda.

Lyckligtvis så finns det flera sätt att sänka en enhetens WA värde. Den mest uppenbara är förstås SandForce komprimeringsteknik som komprimerar all data innan den skrivs till minnet. Mindre data som ska skrivas blir lägre WA. Tre andra sätt är väldigt vanliga och används av många SSD:er idag så vi tänkte vi skulle gå igenom dem.

TRIM

TRIM fick väldigt mycket uppmärksamhet för två år sedan när det först kom. TRIM är numera en självklar funktion och alla dagens SSD-enheter har stöd för det, men hur funkar det?

Som vi vet så ökar WA och prestandan sjunker när en SSD måste radera gammal data för att sedan skriva över med ny (se ovan för mer detaljerad förklaring). Det är inga problem så länge minnescellerna är tomma när det är dags att skriva och det är därför som enheten funkar bättre efter en så kallad Secure Erase, som i praktiken raderar alla minnesceller på hela enheten.

När du raderar en fil så säger ditt operativsystem åt filsystemet: ”Den här filen har raderats. Den finns inte längre”. Filsystemet tar bort informationen om filen men all data som filen innehåller, ligger fortfarande kvar på lagringsmediet. Gamla hårddiskar kunde nämligen bara skriva över gammal data med ny, så om det låg kvar gammal data där spelade ingen roll. Med SSD så skapar detta ett problem. På en SSD med 120 gigabyte så räcker det med att du skriver totalt 120 gigabyte med data till enheten, så är alla minnesceller fulla oavsett om du raderar filer eller inte.

TRIM är helt enkelt ett kommando som skickas från operativsystemet till SSD kontrollern och talar om för den när något raderas. Tar du bort en fil på ett system som har TRIM aktiverat så skickas information om vilken fil som ska raderas, till SSD kontrollern som sedan raderar all data som har med den filen att göra. På det sättet så har du fler lediga minnesceller när det är dags att skriva ny data.

Om du ska köra med en SSD så var noga med att du väljer ett OS som har stöd för TRIM. De OS som i skrivande stund har stöd för TRIM är Windows 7, Windows Server 2008 R2, OS X 10.6.8 eller senare (Apple SSD:er endast), OpenSolaris, Linux v 2.6.28 eller senare och FreeBSD 8.1 eller senare.

Garbage Collection

Ett annat sätt att bibehålla en prestandan i din SSD är via så kallad garbage collection. GC är algoritmer och funktioner som är inbyggda i SSD kontrollern. Syftet är att ”städa” SSD-enheten. Detta görs givetvis på flera olika sätt men kan också implementeras olika och varierar därför olika från tillverkare till tillverkare. Det som händer är att när många sidor blir halvfulla flyttar kontrollern sin data till nya sidor och klumpar ihop dem. Istället för att ha 10 halvfulla sidor så får man 5 stycken fulla och 5 stycken tomma. Man kan säga att GC är en slags defragmentering av en SSD. När och hur GC startar och hur mycket av enhetens resurser den använder, är helt upp till varje tillverkare.

Ett sätt är att använda det vi valt att kalla för aktiv GC. Då passar man på att städa enheten samtidigt som man skriver data. t.ex. om du ändå måste skriva om vissa delar av ett block för att ett block innehåller data från olika filer, så tar man och skriver dessa till ett nytt block och därmed ”sorterar” datan för att slippa skriva om samma data igen vid ett senare tillfälle. Följden blir att du får något sämre prestanda när du skriver data, men prestandan återhämtar sig lite mer och mer för varje gång ny data skrivs. Bland annat SandForce-enheter använder sig av den här metoden.

Ett annat sätt är att använda det vi kallar passiv GC. Det fungerar ungefär likadant som aktiv, men istället för att städa när enheten ändå skriver ny data, så gör man detta istället när enheten ligger i vila. Vissa tillverkare väljer att enheten måste vila i ett visst antal minuter innan GC körs igång. Vissa enheter triggar betydligt snabbare och börjar städa så fort enheten inte har något jobb alls.

Fördelarna med passiv är att skrivprestandan inte påverkas alls då man utnyttjar enhetens ”dötid” istället. Nackdelen är att hela proceduren med läs, skriv, radera, läs, skriv, måste göras hela tiden, med högre WA som följd. En annan nackdel är så länge enheten arbetar aktivt så kommer prestandan att sjunka. För konsumentmarknaden är det inget problem, men för företag som har stor belastning på sina servrar så kan det blir ett problem.

Over-provisoning

Vi har tidigare beskrivit hur en SSD måste flytta på data för att kunna skriva ny data. Ett annat problem uppstår när det inte finns någon plats ledig att använda som mellanlagring. Då måste enheten först flytta data för att kunna göra plats för att kunna mellanlagra data som ändå ska vara på en helt annan plats. Ledigt utrymme gör det helt enkelt enklare för enheten att flytta runt data utan att WA rusar iväg.

Att kunna lagra data på allt tillgängligt utrymme gör att det finns en risk att stänga in enheten i ett hörn. Fyller du hela enheten med data och sedan försöker skriva ny data så kommer enheten få svårt att hålla prestandan uppe. Därför använder man ibland något som kallas för Overprovisioning. Overprovisioning är egentligen ett sätt att ge kontrollern tillgång till mer lagringsutrymme än vad användaren får. Intel har tillämpat detta flera gånger men annars är det vanligare på Enterprise-enheter. Om man vill vara lite extra rädd om sin SSD så kan man göra lite Overprovisioning själv. Istället för att göra en partition på allt tillgängligt utrymme, så kan man göra en partition som är 10 gigabyte mindre och sedan låta resten vara opartitionerad. Då kan du aldrig fylla din SSD fullt ut, och då har alltid enheten en utväg.

För att demonstrera hur Overprovisioning kan hjälpa till i verkligen så gjorde vi ett litet test. Vi tog en OCZ Vertex 3 120 gigabyte och gjorde en Secure Erase på den. Sedan bombarderade vi enheten med Slumpmässig data på 4K under 30 min. För att göra det lite extra jobbigt så använde vi okomprimerbar data för att SandForce kontrollern skulle få jobba ordentligt. En gång varje minut så mäter vi prestandan i antalet IOPS för att se hur enheten reagerar över tiden. När testet var klart så gjorde vi en ny Secure Erase (för att återställa enheten till ”ny”). Sedan fyllde vi enheten med okomprimerbar data och gjorde om samma test.

Vi gjorde om testet totalt sex gånger med olika mycket Overprovisioning. Resultatet ser ni i diagrammet här nedan. Ni måste trycka på bilden för att kunna se ordentligt då diagrammet inte får plats på sidan.

När enheten är helt tom så håller sig prestandan runt 30 000 IOPS i 17-18 min för att sedan falla ner och stabilisera sig vid 8 000 – 9 000 IOPS. Men när vi fyllt enheten helt så sjunker prestandan väldigt drastiskt och återhämtar sig aldrig riktigt. När enheten får 1 gigabyte ledigt så ökar prestandan något och hamnar lite högre överlag. Vid 2 gigabyte ledigt så ökar prestandan ytterligare lite grann men fortfarande väldigt långt ner. När vi ökar till 4 gigabyte och 8 gigabyte så ser vi en rejäl ökning i prestanda. Till att börja med så håller sig enheten på cirka 30 000 IOPS i ungefär två minuter och sedan sjunker den, men inte alls lika mycket som tidigare. Samma sak händer när vi ökar ytterligare till 16 gigabyte . Enheten håller full hastighet under en längre period (tills det extra utrymmet är fullt) och sedan håller sig enheten på en generellt högre nivå.

Vi passade även på att mäta hur hög Write Amplification man får vid de olika testerna. I tabellen nedan ser vi vilken WA faktor som vi fick vid varje testtillfälle. 1,00x innebär att det skrev exakt lika mycket data till NAND som skrevs av filsystemet, 5,00 x innebär att det skrev 5 gånger mer data till NAND än vad som skrevs av filsystemet.

| Ledigt | Write Amplification Factor (WAF) |

| 0GB | 13,22x |

| 1GB | 10,78x |

| 2GB | 9,40x |

| 4GB | 7,41x |

| 8GB | 5,46x |

| 16GB | 3,82x |

| 119GB (Tom) | 1,53x |

| 0GB (som går att komprimera) | 1,59x |

Vi kan tydligt se att ju mer utrymme som finns ledigt, desto lägre blir WA. Vi ser också att när vi fyller enheten med data som SandForce-kontrollen lätt kan komprimera, så ökar WA inte speciellt mycket. Detta är givetvis ett väldigt extremt fall, men det visar hur pass viktigt Overprovisioning är för enhetens prestanda och livslängd.

Varit nöjd och är nöjd med min crucial M4 128gb som tutar på 2 år senare.

samma pris som då får man 256gb idag.

men vilket test heh.

Wow säger jag bara! Otroligt! Vilket hästjobb som måste legat bakom detta! Tummen upp!

[quote name=”Marquzz”]Wow säger jag bara! Otroligt! Vilket hästjobb som måste legat bakom detta! Tummen upp![/quote]Jo det har tagit ett tag. Om man räknar ihop den totala tiden som testandet har kört och lägger det en sekvenens, så har jag testat i ungefär två veckor 🙂 Men som sagt, Grovjobbet är gjort nu och det kommer bli betydligt enklare för mig att testa nya enheter i framtiden. Så är den enhet ni saknar så är det bara att säga till. Då ska jag försöka fixa så den kommer med. Är det några frågetecken får ni gärna skicka ett mail eller PM… Läs hela »

WoW!

Underbar artikel.

Håller med om att Plextor SSDer är dyrare än de flesta andra, men å andra sidan har jag inget att klaga på angående kvalitén eller hastigheten.

Visst, det kostar lite extra (999 kr för min 128GB M3 när den införskaffades) men jag upplever det som värt det för att slippa allt krångel.

Yeah, I’m pretty excited too! Oh, I have a question for you. What do you think about this one https://campobet.se/sv/

[quote name=”xemacs”]WoW!

Underbar artikel.

Håller med om att Plextor SSDer är dyrare än de flesta andra, men å andra sidan har jag inget att klaga på angående kvalitén eller hastigheten.

Visst, det kostar lite extra (999 kr för min 128GB M3 när den införskaffades) men jag upplever det som värt det för att slippa allt krångel.[/quote]

Absolut. Jag gillar alla Plextors enheter. Särskillt M5 PRO då förståss ;). Den är verkligt med och slåss bland de vassaste enheterna. jag kan inte förstå varför de ska vara så mycket dyrare i Sverige. De är inte så dyrta utomlands.

Kan nämnas att många ssd med nyare kontrollers kanske inte är helt optimala för äldre moderkort.

För en oinvigd så vill de köpa ssd men om deras moderkort är äldre kan det uppstå lite problem med kompatibilitet.

Även som en som suttit med hela resan, eller kanske ännu mer för mig, så är detta den mäktigaste artikeln vi publicerat på NH under de snart 12 år vi varit aktiva. Ser vi till själva SSD-marknaden är det riktigt kul att vi faktiskt har en handfull olika kontrollerkretsar med riktigt konkurrenskraftig prestanda. Det bådar för en spännande framtid på SSD-marknaden helt klart.Ser även fram emot att se Intels nya enterprisekontroller i konsumentenheter. Förutom att Samsung imponerar riktigt stort i prestanda är det riktigt kul att se hur 240-256GB enheterna verkligen kommit till sin rätt prismässigt. Inte minst med tanke… Läs hela »

Grymt imponerad Gustav. Sjukt bra jobbat 😀

[quote name=”Anders Nilsson”]Grymt imponerad Gustav. Sjukt bra jobbat :D[/quote]

Tack så mycket 🙂

Otroligt bra test.Gillade speciellt de egenkomponerade testsviterna,mycket bra jobbat!.

Det här kommer bli det test jag rekommenderar alla ssd-köpsugna att läsa.

Och med fortlöpande uppdateringar så är det alltid aktuellt.

Tack så hemskt mycket.

Jag tror någon på redaktionen får avstå från kaffe ett tag framöver.

Som 830 ägare blir man glad över att ha gjort ett bra val.

Har faktiskt tankar att skaffa en SSD trots mina negativa åsikter om dessa drivar. Det lär bli en 120 – 128GB version i alla fall. Jag brukar inte ha mer än 65GB på min hårddisk (med spelen inräknade) så det lär räcka för min del

Samsung 830 128GB ligger på min favoritlista efter att ha läst testet

Jag har två Corsair SSD som är ca 2år gamle och båda får ”Health Status Critical” när jag kontrollerar med CrystalDiskInfo. Disken är inte alls 90GB längre heller utan har krympt ordentligt på grund av skadade minnesceller. Drift tiden är på 8170 timmar och total skrivning på endast 5,7TB och FireFox cachen står för ca 70% av det all på grund av att min dotter hela tiden spelar massa olika flash-spel. Nu för tiden så har risken för detta minskat dels på grund av att diskarna har blivit större och där med skrivs inte cachen över lika ofta och dels… Läs hela »

Grym artikel!

Till Gustav Gager och övriga som arbetat med denna fantastiska guide vill jag bara säga att ni verkligen har gjort ett toppen arbete. Informativt och bra skrivet med mycket fakta. Särskilt tycker jag ni gjort det väldigt bra med informationssidorna i början av artikeln, men självklart alla testerna också samt bra sammanfattning med prisguidning på slutet. Kanske det blir aktuellt med en uppdatering eller notis på eran sida framöver om Samsungs 840 Pro pga. att det tydligen skall(?) släppas en viktig Firmware uppdatering snart, för att åtgärda något kritiskt fel. Det är väl inte riktigt klart där än med dessa… Läs hela »

Hej,

Grymt test.

Det vore kul om Verbatims prisvärda SSD kom med i framtiden.

[quote name=”Morkul”]Jag har två Corsair SSD som är ca 2år gamle och båda får ”Health Status Critical” när jag kontrollerar med CrystalDiskInfo. Disken är inte alls 90GB längre heller utan har krympt ordentligt på grund av skadade minnesceller. Drift tiden är på 8170 timmar och total skrivning på endast 5,7TB och FireFox cachen står för ca 70% av det all på grund av att min dotter hela tiden spelar massa olika flash-spel. Nu för tiden så har risken för detta minskat dels på grund av att diskarna har blivit större och där med skrivs inte cachen över lika ofta och… Läs hela »

[quote name=”Flyfisherman”]Till Gustav Gager och övriga som arbetat med denna fantastiska guide vill jag bara säga att ni verkligen har gjort ett toppen arbete. Informativt och bra skrivet med mycket fakta. Särskilt tycker jag ni gjort det väldigt bra med informationssidorna i början av artikeln, men självklart alla testerna också samt bra sammanfattning med prisguidning på slutet. Kanske det blir aktuellt med en uppdatering eller notis på eran sida framöver om Samsungs 840 Pro pga. att det tydligen skall(?) släppas en viktig Firmware uppdatering snart, för att åtgärda något kritiskt fel. Det är väl inte riktigt klart där än med… Läs hela »

Köpte två Hyper X förra julen för strax under 1000lapppen, bra köp och det priset då var det ingen som slog… och 5000 skrivningar känns en hel del bättre än 3000.

Guiden har nu fått sin första uppdatering. Förändringar ses enklast på guidens förstasida.

[quote name=”Tempel”]Köpte två Hyper X förra julen för strax under 1000lapppen, bra köp och det priset då var det ingen som slog… och 5000 skrivningar känns en hel del bättre än 3000.[/quote]

Alla produkter påverkas givetvis mycket av priset, rea osv. Men SSD-enheter i synnerhet där det är så många bra enheter på marknaden och så lite som skiljer att priset ofta blir en extra stor faktor. Så har man tur och är påpasslig när det är rea eller specialerbjudande kan man göra riktiga kap som står sig rätt länge sett till pris/prestanda.

[quote name=”-Tjalve-”][quote name=”Marquzz”]Wow säger jag bara! Otroligt! Vilket hästjobb som måste legat bakom detta! Tummen upp![/quote]Jo det har tagit ett tag. Om man räknar ihop den totala tiden som testandet har kört och lägger det en sekvenens, så har jag testat i ungefär två veckor 🙂 Men som sagt, Grovjobbet är gjort nu och det kommer bli betydligt enklare för mig att testa nya enheter i framtiden. Så är den enhet ni saknar så är det bara att säga till. Då ska jag försöka fixa så den kommer med. Är det några frågetecken får ni gärna skicka ett mail eller… Läs hela »

[quote name=”Pelle Svanslös”]

Kommer ni uppdatera notisen om Samsung 840 Pro så fort ni får någon info om probelemet med de ”döda” diskarna?[/quote]

Artikelns syfte är att uppdateras löpande och alltid vara up-to-date 🙂

[quote name=”Verbatim”]Hej,

Grymt test.

Det vore kul om Verbatims prisvärda SSD kom med i framtiden.[/quote]

Menar du Verbatim SSD 128GB som vi testade för några månader sedan?

Grymt test, en stor eloge igen för de många modeller ni får med. Hade som vanligt gärna sett fler storlekar i samma modell serier testade men jag vet att ni försöker och att ni får ett begränsat material att arbeta med. Har själv en 128Gb Corsair performance pro som jag införskaffade efter ert test av den disken och jag är mycket nöjd med det köpet. Är hästlängder bättre än den vertex 3 jag bytte från. (den kostade dock mindre när jag köpte den än de gör nu konstigt nog, inte mycke men iaf) Återigen tack för alla fina recensioner och… Läs hela »

[quote name=”-Tjalve-”]Hej Morkul. Jag tycker detta verkar väldigt intressant då det är flera parametrar som inte riktigt stämmer för mig. Först och främst, vilken modell är det du har? Eftersom det är 90GB så skulle jag gissa att det är en Corsair Force kanske? Jag har gjort ett litet snabb test för att försöka räkna ut ungefär hur mycket data som kan skrivas till en Corsair Force 40GB. Jag körde aldrig riktigt klart testet och det faktiska antalet skrivningar till NAND står inte i SMART data för dessa enheter. Men jag använder mig av okomprimerad sekventiell skrivning och det borde… Läs hela »

Jag tycker detta är ett mycket bra initiativ! Jag återkommer och läser nhw ofta just pga av era SSD-tester. Detta uppskattas mkt!

En fråga: vet ni något om när Intels SSD DC S3700? När kommer den? När får ni in den för test?

Mvh Jackuel

Detta test visar verkligen att man inte ska hoppa på nya diskar, utan avvakta minst ett halvår för att se hur de är. Tekniken är onekligen fortfarande ny och rätt obeprövad. Jag skulle tro att priskrig och jakten på ökad prestanda har lätt till minskad kvalité. Hellre en långsammare och pålitlig disk än en snabb som kraschar och med minskad prestanda som följd av dålig mjukvara. Jag har själv en Corsair GT och en A-data bägge med Sandforce SF-2200 och de har fungerat bra och varit stabila i nåt halvår nu. Datorn med Corsairen har blåskärmat kanske 4 ggr sen… Läs hela »

[quote name=”Morkul”]Nu skickade jag tyvärr iväg mina två diskar till Corsair, annars hade jag kunnat skickat en till dig så att du hade fått kolla. Corsair skickade dock en ny disk till mig som tack för hjälpen 🙂 Svaret jag fick av Corsair var: På grund av att disken var så pass liten och system plus lite program tog upp så pass stor andel av disken så blev ett litet antal celler hårt belastade utav cache skrivningarna. Om det stämmer så kan du inte simulera det med hjälp av långa sekventiella skrivningar eftersom det kommer belasta flera celler. Enligt Corsair… Läs hela »

[quote name=”Jackuel”]Jag tycker detta är ett mycket bra initiativ! Jag återkommer och läser nhw ofta just pga av era SSD-tester. Detta uppskattas mkt! En fråga: vet ni något om när Intels SSD DC S3700? När kommer den? När får ni in den för test? Mvh Jackuel[/quote] Hej. Kul att du tittar in hos oss och läser våra tester. Då kommer det finns mycket för dig i framtiden också vill jag lova 😉 Angående Intel DC S3700 så är det onekligen en mycket intressant SSD. Just med tanke på att det är Intels första egentillverkade SATA 6Gbps kontroller. Just DC S3700… Läs hela »

[quote name=”Marquzz”]Detta test visar verkligen att man inte ska hoppa på nya diskar, utan avvakta minst ett halvår för att se hur de är. Tekniken är onekligen fortfarande ny och rätt obeprövad. Jag skulle tro att priskrig och jakten på ökad prestanda har lätt till minskad kvalité. Hellre en långsammare och pålitlig disk än en snabb som kraschar och med minskad prestanda som följd av dålig mjukvara. Jag har själv en Corsair GT och en A-data bägge med Sandforce SF-2200 och de har fungerat bra och varit stabila i nåt halvår nu. Datorn med Corsairen har blåskärmat kanske 4 ggr… Läs hela »

[quote name=”-Tjalve-”]Hej igen och tack för ditt svar. Haha attans. Det hade vart spämnnande att kolla på dem 😉 Corsair svar låter också mycket märkligt. Om enheten ifråga inte är från stenålderna (nått i stil med jmicron kontroller) så ska GC och Wear Leveling se till att det inte händer. Om du skriver data till en minnecell och sedan är den minnecellen statisk (Windows installation) då kommer den informationen att flyttas runt till olika platser (Wear Leveling). Det ökar WA ganska dramatiskt, men är nödvändigt för att du inte ska få just det problemet som corsair beskriver. jag tror de… Läs hela »

Jisses vilket bra test, superbra!!!

[quote name=”Morkul”]Intressant att läsa men då undrar jag hur fasen de kan flytta på filer som Windows låser?[/quote] Den flyttar inget, men om du läser upp fil a och skriver ned fil a på vad Windows tror är samma ställe på disken, så ska Wear leveling algorithmen se till att den skrivs på andra mindre utnyttjade minnesceller i verkligheten. Det är en av huvuduppgifterna för en SSD-kontroller och därför låter Corsairs svar väldigt mysko 🙂 Då skulle man som du säger kunna paja enheten genom att läsa/skriva samma fil några tusen ggr. Alltså address 0 är address 54454 fysiskt fösta… Läs hela »

[quote name=”Morkul”][quote name=”-Tjalve-”]Hej igen och tack för ditt svar. Haha attans. Det hade vart spämnnande att kolla på dem 😉 Corsair svar låter också mycket märkligt. Om enheten ifråga inte är från stenålderna (nått i stil med jmicron kontroller) så ska GC och Wear Leveling se till att det inte händer. Om du skriver data till en minnecell och sedan är den minnecellen statisk (Windows installation) då kommer den informationen att flyttas runt till olika platser (Wear Leveling). Det ökar WA ganska dramatiskt, men är nödvändigt för att du inte ska få just det problemet som corsair beskriver. jag tror… Läs hela »

Tack Laglord3n och -Tjalve-!

Känns som jag måste läsa på lite mer om Wear Leveling. Var väl 20 år sedan jag hade koll på det och då gäller det bränning av EMPROM och jag antar att det har hänt lite sedan dess.

[quote name=”Morkul”]Tack Laglord3n och -Tjalve-!

Känns som jag måste läsa på lite mer om Wear Leveling. Var väl 20 år sedan jag hade koll på det och då gäller det bränning av EMPROM och jag antar att det har hänt lite sedan dess.[/quote]

ja du, det är en djungel. Men är du intresserad skulle jag rekomendera att du läser sidorna om SSD-kontroller, olika typer av NAND och Garbage Collection, TRIM, Write Amplification, Overprovisioning

Efter att ha läst en hel del de senaste dagarna angående Wear Leveling börjar jag känna mig inte mer insatt. Det finns två typer av Wear Leveling, statisk och dynamisk och de flesta moderna SSD använder båda typerna. Dynamic wear leveling håller koll på antalet cyklar varje minnesblock har gjort och skriver till de minnesblock som har minst antal skrivningar. Data som det aldrig sker någon förändring av (till exempel systemfiler) kommer aldrig Dynamic wear leveling flytta på. Static wear leveling flyttar runt på statisk data och försöker göra så många minnesblock som möjligt ledigt men helt utan dritekt kontroll… Läs hela »

[quote name=”Morkul”]Efter att ha läst en hel del de senaste dagarna angående Wear Leveling börjar jag känna mig inte mer insatt. Det finns två typer av Wear Leveling, statisk och dynamisk och de flesta moderna SSD använder båda typerna. Dynamic wear leveling håller koll på antalet cyklar varje minnesblock har gjort och skriver till de minnesblock som har minst antal skrivningar. Data som det aldrig sker någon förändring av (till exempel systemfiler) kommer aldrig Dynamic wear leveling flytta på. Static wear leveling flyttar runt på statisk data och försöker göra så många minnesblock som möjligt ledigt men helt utan dritekt… Läs hela »

[quote name=”-Tjalve-”]Du har helt rätt i att det finns 2 olika typer av Wear leveling. SSD-Eneheter använder en kombination av de båda typerna. Delvis för att dynamisk är snabbare än statisk, men även statisk bör köras ibland också. Jag tror inte det finns någon SSD-enhet som använder endast dynamisk wear leveling. Det är mer minneskort och USB-minnen som gör det. Så dina gamla SSDer borde ha ha haft tillgång till statisk wear leveling.[/quote] Jo precis som jag skrev: Det finns två typer av Wear Leveling, statisk och dynamisk och de flesta moderna SSD använder båda typerna. Om mina diskar var… Läs hela »

[quote name=”Morkul”][quote name=”-Tjalve-”]Du har helt rätt i att det finns 2 olika typer av Wear leveling. SSD-Eneheter använder en kombination av de båda typerna. Delvis för att dynamisk är snabbare än statisk, men även statisk bör köras ibland också. Jag tror inte det finns någon SSD-enhet som använder endast dynamisk wear leveling. Det är mer minneskort och USB-minnen som gör det. Så dina gamla SSDer borde ha ha haft tillgång till statisk wear leveling.[/quote] Jo precis som jag skrev: Det finns två typer av Wear Leveling, statisk och dynamisk och de flesta moderna SSD använder båda typerna. Om mina diskar… Läs hela »

[quote name=”-Tjalve-”] Coolt att du har kontakter hos Samsung. Du kanske kan fixa lite ”inside info” till mig då? 😉[/quote] Tyvärr sitter jag under en hel del NDA tyvärr. Men när det kommer till ARM och dess utveckling hos Samsung så finns det en hel del man skulle vilja säga ibland. [quote]Det finns säkert lägen där du kan stänga in alla SSD-enheter i ett hörn (SandForce enheter återhärmtar sig aldrig när man sätter dem i ett visst läge tex, inte ens med TRIM). Jag har dock väldigt svårt att tänka mig att du ska sätta den i ett såndant läge… Läs hela »

[quote name=”Morkul”]Tyvärr sitter jag under en hel del NDA tyvärr. Men när det kommer till ARM och dess utveckling hos Samsung så finns det en hel del man skulle vilja säga ibland.[/quote]Där finns en hel del jag skulle vilja veta också. Bland annat om deras nya MDX kontroller. [quote]Bara för att spåna lite på ett av problemen: När Static Wear Leveling sätter igång och ska flytta på filen så måste filen under ett tag finnas på två ställen eftersom själva pekaren till filen måste peka på en hel fil. Detta för att om ett program skulle försöka öppna/köra filen under… Läs hela »

[quote name=”-Tjalve-”]För det första så kan man inte tänka ”filer” när vi pratar sånt här. När du sparar en fil så kommer filsystemet (NTFS eller FAT eller liknande) att använda sig av något som kallas för LBA. Det är egentligen ett stort adressregister. På en hårddisk så motsvarar en adress i LBA, en fysisk sektor på disken. När det gäller SSD så finns det ett lager emellan. LBA Snackar med SSD kontrollern och SSD kontrollen ger LBA adressen en motsvarande fysiska plats i NAND att lagra datan på. Detta är något som SSD-kontrollern sköter helt själv. LBA, filsystem och OS… Läs hela »

[quote name=”Morkul”]Ja att använda order fil kanske inte var helt korrekt dock håller SSD controllern kontroll på vilka LBA adresser som hör ihop så att den kan sprida ut den på så många kretsar som möjligt. SSDn klara av att läsa från flera kretsar samtidigt vilket ökar så väl las som skriv prestandan. Vissa firmware klarar denna process bättre andra sämre där av att de får olika prestanda trots att det är samma hårdvara. Sedan ska tilläggas att Static Wear Leveling hoppar inte igång om inte disken hamnar i idle, ja det gäller i alla fall Samsungs diskar.[/quote] Olika kontroller… Läs hela »

Varför rekomendera intel 330 240gb före 180gb? Enligt prisjakt har de samma prestanda. Kan vara fel dock.

[quote name=”LosKrikon”]Varför rekomendera intel 330 240gb före 180gb? Enligt prisjakt har de samma prestanda. Kan vara fel dock.[/quote]

Priserna uppdateras hela tiden. Vi försöker att alltid hålla uppdaterade rekommendationer. Tyvärr så kan vi inte uppdatera för varje lite prisskillnad så det kan vara så att det inte alltid stämmer 100%. I det här fallet så rekommenderar vi 330 180GB, inte 240 🙂

Läser:

”För varje extra bit man lägger till så ökar antalet kombinationer logaritmiskt”

Stannar upp – läser igen och känner att något känns fel…

borde inte antalet kombinationer öka exponentiellt, med 8 bitar kan vi ju lagra 2^8=256 olika värden; inte log_2(8)=3 värden…

FANTASTIKST bra artkel, hittade precis allt jag letade efter, mycket jag inte kan om SSD men troligen blir jag mer lärd när jag läst mig i genom

Bra jobbat Gager 😉

[quote name=”Rasmus Nyman”]Läser:

”För varje extra bit man lägger till så ökar antalet kombinationer logaritmiskt”

Stannar upp – läser igen och känner att något känns fel…

borde inte antalet kombinationer öka exponentiellt, med 8 bitar kan vi ju lagra 2^8=256 olika värden; inte log_2(8)=3 värden…[/quote]

Hej Rasmus. Du har helt rätt. En så kallad ”brain fart” från min sida. Givetvis ska det vara exponentiellt och jag har nu åtgärda detta.

Tack.