En närmare titt på GPU Boost

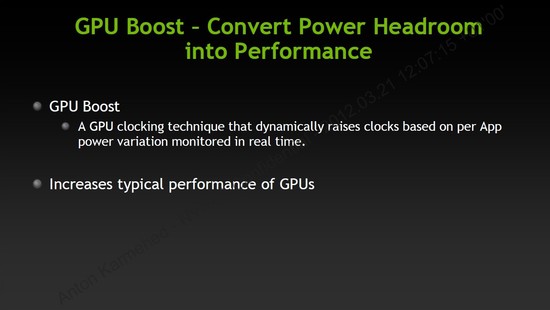

Vi vet nu grunden för vad GPU Boost är, eller i alla fall konceptet bakom tekniken. Den stora frågan nu är, exakt hur fungerar det, och hur påverkar det mig som slutanvändare? En av de punkterna som gjort att lanseringen av Kepler dragit ut på tiden är GPU Boost, då de ville få den nya tekniken dit de ville ha den.

Ett hundra millisekunder

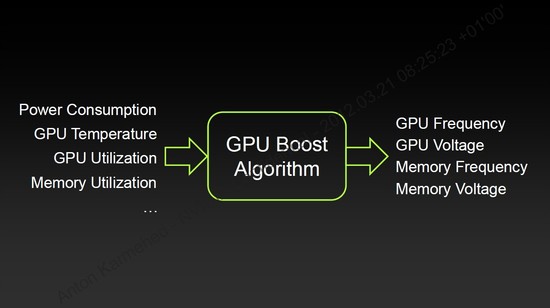

Vi säger att grafikkortet kan ändra både klockfrekvens och spänning dynamiskt – men hur ofta? GPU Boost bygger på teknik som finns inbyggt i grafikkretsen, men även dedikera logik på kretskortet som mäter av strömförbrukningen en gång varje hundra millisekunder, eller varje tiondelssekund om man så vill. Det är även så ofta som grafikfrekvensen och spänningen kan ändras.

Den här tiden är en evighet för någonting som ett grafikkort, som utför flera miljarder beräkningar i sekunden. Belastningen skiftar oftast i spel när man går in i nya miljöer, eller spelar på en ny bana så i de flesta fallen bör det här inte vara något problem. Vi ser dock hur det potentiellt skulle kunna upplevas som micro-stutter, någonting vi diskuterade även med andra medier på vårt besök i San Francisco. Men utifrån den demonstration vi fick, samt våra egna tester så är det här inget problem som vi har kunnat märka av.

GPU Boost har inga fasta specifikationer, och det är här som vi kan tycka att NVIDIA gjort ett bra jobb. GeForce GTX 680 kommer med en klockfrekvens på 1 006 MHz, och en så kallade Boost Clock på 1 058 MHz. Boost Clock är den klockfrekvens alla användare kommer att stöta på många gånger – det är vad NVIDIA garanterar. GPU Boost tillåter ännu högre klockfrekvenser, och den inbyggda logiken mäter kontinuerligt av strömförbrukningen.

Det finns ingen gräns för vad GPU Boost klarar, utan den kan öka i steg av ett fåtal MHz åt gången, och i GeForce GTX 680 ser stegen ut att ligga på 13 MHz åt gången (1 058, 1 071, 1 084, 1 097 MHz och så vidare). Klockfrekvenser på över 1 100 MHz väntar vi oss att alla kommer nå med NVIDIA:s nya funktion någon gång, men som vi tidigare förklarat beror detta helt på vilka spel man spelar och hur krävande en specifik titel är är.

GPU Boost – olika från grafikkort till grafikkort

Men inom halvledarindustrin finns ett problem, eller som för många överklockare anses vara en sport. Varje krets är unik på sitt sätt, de skiftar i kvalité och tolerans. Vissa överklockas högt med låg spänning, andra behöver högre spänning för lägre klockfrekvenser, medan andra kretsar faller någonstans där emellan. Borde inte samma sak gäller med GPU Boost?

Den här verkligheten erkände NVIDIA; prestandan i GeForce GTX 680 kommer att variera lite mellan olika exemplar. Som exempel, kanske ett grafikkort klarar av att spela Battlefield 3 i 1 100 MHz kontinuerligt, medan ett annat klarar av hela 1 150 MHz i samma spel med samma inställningar. När vi frågade om de ansåg att det här var ett problem så möttes vi av en vägg som i princip sa; Varför skulle det vara ett problem, användarna får ju gratis prestanda.

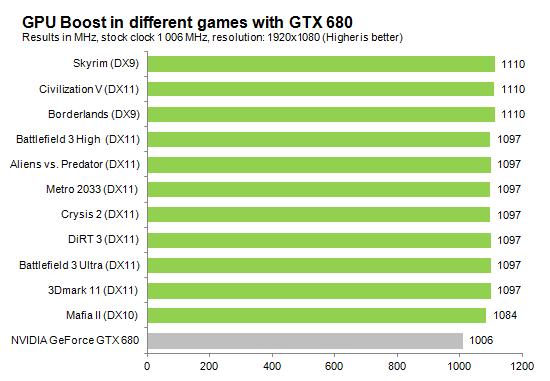

Ovan har ni resultaten på vårt exemplar av GeForce GTX 680, och som vi ser arbetar den aldrig i sin standard frekvens på 1 006 MHz. Lägsta vi mäter av är i Mafia II, där grafikkortet ”bara” jobbar i 1 084 MHz medan det i övriga titlar går i antingen 1 097 eller 1 110 MHz. Det här är toppvärdena i våra tester, och det finns i de flesta spel variationer på 13 eller 26 MHz under dessa då GPU Boost dynamiskt ändrar både klockfrekvens och spänning. Medan i andra titlar håller sig klockfrekvensen konstant på de värden vi listat.

Precis som vi förklarat så skiljer GPU Boost från grafikkort till grafikkort, därmed klockfrekvens och prestanda. Så ta våra siffror endast som en fingervisning, då just det kort man plockar upp i handeln kan vara både bättre eller sämre än vårt testexemplar. Det är därför svårt att lägga en exakt vetenskap bakom tekniken, så ni får ta våra resultat för vad det är.

Funktionen går inte att stänga av

För oss som testat kortet, men även för överklockare får det här ses som inget annat än dåliga nyheter. GPU Boost går inte att stänga av, och detta av den enkla anledningen att NVIDIA inte vill att det ska gå. Det här betyder att prestandaresultaten kan skifta något mellan varje gång man kör ett test, eller spelar ett spel. Vid överklockning innebär det att klockfrekvensen och spänning kommer att skjuta i höjden, utöver de ökningar man gjort manuellt. NVIDIA demonstrerade när de överklockade grafikkortet till 1 200 MHz, men i spel så steg det till strax över 1 300 MHz.

Nu när vi har diverse turbo-tekniker i både våra processorer och grafikkort, som för varje generation blir bättre och får större svängrum kan vi inte låta bli att fråga oss en sak. Hur relevant, eller hur nödvändigt kommer överklockning vara i framtiden när NVIDIA, Intel och AMD sköter jobbet åt oss?

Jag vill ha tillbaka heatspreadern. 🙁

[quote name=”Mean Machine”]Jag vill ha tillbaka heatspreadern. :([/quote]

Du har inga problem med GPU Boost? 🙂

Är väl iofs förhoppningsvis lättare löst än att sätta på en heatspreader i efterhand.

Enda AMD kan göra nu är väl att sänka priset på dom har och se till att det finns att tillgå i handeln.

[quote name=”IcedEarth”]Enda AMD kan göra nu är väl att sänka priset på dom har och se till att det finns att tillgå i handeln.[/quote]

Ja det kan vi garanterat räkna med. Priserna i svenska butiker verkar bli lägre än vad vi fick information om först, finns kort för runt 4600 kronor redan.

Så detta lär bara betyda mer prestanda för pengarna de närmaste månaderna. 🙂

Äh. Det kommer nog bättre grejer och inofficiella BIOS framöver, GPU Boost är jag inte helt orolig över. Heatspreadern gjorde dock 200MHz GPU-frekvens på GTX 580 med riktig kylning. 🙂

^^ gillar verkligen eran surround del

Hatten av till Nvidia och Nordichardware för grafikkortet och recensionen! 🙂

Nvidia har vänt på allt och nu finns där ingen större anledning att skaffa sig HD7970 över ett GTX 680.

Tror ni AMD kan kontra detta på något sätt? Antar att optimerade drivrutiner inte kan ta igen Nvidia försprång?

Sen har ni hört något om Nvidia kommande kort som GTX 670 och GTX 660TI? Skulle vara kul att veta när dessa kan tänkas att lanseras på marknaden.

Tycker dom drar rätt jämt i högre upplösning och directcompute prestandan är ju ett skämt. Nah jag är nöjd med mitt 7970.

AMD borde svara med att ge nuvarande ägare av HD79** en fet drivrutin och sänka priset på alla sina kort med ca 10-20% för att komma jämnt med vad dem presterar mot 680.

[quote name=”pippen1001″]^^ gillar verkligen eran surround del[/quote]Vi fick inte fullt så mycket tid till Surround som vi hade hoppats men vi fick med de mer intressanta titlarna och det blir mer av den här varan framöver. Kanske tom lite 3D Vision Surround.. 😉[quote name=”Swedish Berserk”]Hatten av till Nvidia och Nordichardware för grafikkortet och recensionen! 🙂 Nvidia har vänt på allt och nu finns där ingen större anledning att skaffa sig HD7970 över ett GTX 680. Tror ni AMD kan kontra detta på något sätt? Antar att optimerade drivrutiner inte kan ta igen Nvidia försprång? Sen har ni hört något om… Läs hela »

Första gången jag läste igenom er recension fullt ut och jag kan inget annat än tacka NH för väldigt bra arbete.Mycket intressant att få läsa lite historia om 680 uppkomst och planerna för kortet. Man måste vara ett inbitet AMD-fan om man väljer något av deras kort framför detta.Inte nog med att man rätt och slätt är snabbare än AMD i alla väsentliga titlar, så drar man mindre ström samtidigt som man kostar någonstans mellan av vad AMD Radeon 7950 och 7970 gör.När nVidia en vacker dag släpper Forceware version mognare, fortsätter man med GTX 680 momentum där prestandaökning med… Läs hela »

Jag tycker det ser riktigt bra ut. Jag gillar framförallt att det är ett kort som inte drar så extremt mycket ström eller blir överlägset varmt.

Jag tror det kan bli bra det här 🙂

Mer konkurans åt folket!

[quote name=”Anton Karmehed”]Prissänkningar kommer alla gånger, problemet för AMD är att Tahiti XT inte bara presterar sämre. Den är även dyrare att tillverka pga kretsstorleken. Så NVIDIA kan om man vill göra livet jäkligt surt för AMD.[/quote]

Hellre förlora mindre pengar än mycket ^^

Jättefin recension! Det enda som var lite ”minus” var att texterna under diagrammen var lite mer ”pro nVidia” än staplarna i vissa fall… Om man ska vara petig. Ser ju jättebra ut för nVidia sett till spelprestanda men är ju nästan katastrof på OpenCL sidan om detta är resultat som håller sig. Speciellt nu när flera rendereringsverktyg stödjer OpenCL. Jag menar när OpenCl blir större backar nVidia på en av sina starkaste punkter. Men iom att det inte rör sig om det ”egentliga” entusiastkortet kanske detta kommer förändras. MeanMachine: det nvidia ger med ena handen tar de med den andra…… Läs hela »

McKinley: Kul att höra, de här lanseringarna är de tyngsta för oss både tids och arbetsmässigt så det är skönt att det uppskattas. 😉 SuperNova: Jag måste erkänna att jag efter våra prestandatester när vi kört om med Catalyst 12.2 var om inte besviken så i alla fall mindre exalterad över GTX680. Men när jag väl satte in alla resultat i diagrammen så såg det återigen bättre ut för NVIDIA än vad känslan hade varit under vissa av testerna. Det som är det roliga med att göra de här testerna, det är inte förrän man själv ser våra diagram som… Läs hela »

jag tycker funktionen med adaptive vsync verkar asgrym. Hoppas det funkar är less på småryck som alltid är oavsett om man har vsync på eller ej

Första gången på länge som jag kan tänka mig att köpa ett Nvidia kort igen. Dom har ju bytt plats på marknaden med AMD.

Strömsnål billig krets som bara satsar på spelprestanda. AMD har slösat bort mycket kraft på directcompute som väldigt liten del av användarna använder.

Däremot verkar 7900-serien klocka högre så maxklockade lär HD7970 och GTX680 prestera jämnt.

Om de hade tänkt det som ett mellansegmentskort först, undrar man ju lite vad de har för marginaler på priset.

De borde sålt det för 2500 och tagit över marknaden helt.

Nu har vi ett oligopol istället där konsumenterna blir blåsta på en massa pengar.

Det är väl ingen som blir blåst, kortet kostar i princip lika mycket som ett HD 7970 idag fast med något högre prestanda och lägre strömförbrukning?

Det här är inte första gången ett företag tar chansen och sätter sitt pris högre, och inte heller den sista, det är självklart att man gör det i NVIDIA:s skor.

Det går rykten om att det kortet som nh testade hade vattenskador efter anton när han dreglade över att få testa det.

Som tur så använder alla på nh nu hakklapp för att undvika misstaget med vatten i hårdvaran. :-*

Bra test gubbar : )

[quote name=”smartidiot89″]Det är väl ingen som blir blåst, kortet kostar i princip lika mycket som ett HD 7970 idag fast med något högre prestanda och lägre strömförbrukning?

Det här är inte första gången ett företag tar chansen och sätter sitt pris högre, och inte heller den sista, det är självklart att man gör det i NVIDIA:s skor.[/quote]

Hur tänker du nu? Det är väl klart att konsumenterna blir blåsta om ett företag kan sätta överpriser på grund av ett oligopol.

Mycket bra artikel! Jag har alltid varit en ati/amd fan men efter jag har nvidia 540m och läser dem nya artiklar så är jag på nvidias sida; bättre drivrutiner och i detta fall effektivare gpu.

Jag är förvånad att den bara har 256bit GDDR5… för att vara deras high-end card.

Nu vet jag inte hur det ligger till men jag skulle aldrig köpa detta kort om det är så att den egentligen skulle kosta hälf av det vad den kostar; jag läste någonstans om det på vr-zone om det.

Anyhow, bra gjort av nvidia att lansera ett effektiv kort på marknaden!

[quote name=”Martin J”]Hur tänker du nu? Det är väl klart att konsumenterna blir blåsta om ett företag kan sätta överpriser på grund av ett oligopol.[/quote]Jag tänker väl som jag skriver, det är ett bra kort för pengarna 🙂 NVIDIA sätter inget överpris, det kommer kosta drygt lika mycket som ett HD 7970 så det talar för att det blir ett priskrig. NVIDIA är ett vinstdrivande aktiebolag precis som alla andra företag i den här branschen, det är deras skyldighet att ta sådana här chanser när det kommer. Men det ändrar fortfarande inte det faktum att GTX 680 är ett bättre… Läs hela »

Jättebra recension gillar speciellt Surround delen i testet!

En liten fundering bara, ni skriver som nackdel ”Det dyraste kortet på marknaden”

Men lite snabb priskontroll så verkar det snarare som att HD7970 korten än så länge fortfarande dyrare än dessa så jag förstår inte riktigt motivationen.

/Danne

priserna kan variera en del så här precis vid släppen men vid tillfället för recensionen såg prisbilden ut så

Bra recension, bra bilder också. Kul att det tas från olika vinklar. Jag tror jag får ta och köpa denna under Maj månad inför Diablo 3 lanseringen. Skulle vara kul att se en uppdatering av recensionen med D3 på testet.

[quote name=”smartidiot89″]Jag tänker väl som jag skriver, det är ett bra kort för pengarna 🙂 NVIDIA sätter inget överpris, det kommer kosta drygt lika mycket som ett HD 7970 så det talar för att det blir ett priskrig. NVIDIA är ett vinstdrivande aktiebolag precis som alla andra företag i den här branschen, det är deras skyldighet att ta sådana här chanser när det kommer. Men det ändrar fortfarande inte det faktum att GTX 680 är ett bättre kort än HD 7970 till ungefär samma pris, förhoppningsvis svarar AMD med lägre priser snart :-)[/quote]Jag förstår inte ditt resonemang. har du för… Läs hela »

🙁 fel, finns inte DX11.1 på GTX680

Jag vill ha DX11.1.

Mitt resonemang är att företag prissätter [u][b]alltid[/b][/u] sina produkter efter hur deras konkurrenters produkter ser ut, ingen av dem sysslar med välgörenhet. Det finns mycket få undantagsfall i detta. Faktum kvarstår att med tanke på hur GTX 680 ser ut hade NVIDIA kunnat sätta priset ännu högre och fortfarande vara konkurrenskraftigt med HD 7970. Att de hade planerade att ha de som ett mellanklasskort (ersättare till GTX 560 Ti) är irrelevant. Priset är en av de allra sista saker som spikas inom den här industrin, inte ens NVIDIA:s egna representanter visste exakt hur prisuppgifterna såg ut när vi träffade dem… Läs hela »

Så sjukt sugen man blir på ett kraftfullt miniITX-bygge med nästa gen intel core i7 och ett GTX 680 när man läser detta. Perfekt för en 1080p-tv och Skyrim med handkontroll 🙂

[quote name=”smartidiot89″]Mitt resonemang är att företag prissätter alltid sina produkter efter hur deras konkurrenters produkter ser ut, ingen av dem sysslar med välgörenhet. Det finns mycket få undantagsfall i detta. Faktum kvarstår att med tanke på hur GTX 680 ser ut hade NVIDIA kunnat sätta priset ännu högre och fortfarande vara konkurrenskraftigt med HD 7970. Att de hade planerade att ha de som ett mellanklasskort (ersättare till GTX 560 Ti) är irrelevant. Priset är en av de allra sista saker som spikas inom den här industrin, inte ens NVIDIA:s egna representanter visste exakt hur prisuppgifterna såg ut när vi träffade… Läs hela »

[quote name=”Kinc”]Så sjukt sugen man blir på ett kraftfullt miniITX-bygge med nästa gen intel core i7 och ett GTX 680 när man läser detta. Perfekt för en 1080p-tv och Skyrim med handkontroll :-)[/quote]

Då kan man ju lika gärna köpa en xbox ju 😛

jag tyckte gott de kunde (ia alla fall försökt) göra ett PC interface denna gång, men noooo…

[quote name=”Martin J”]OK. Jag ger upp. Du resonerar på samma sätt som jag men drar slutsatsen att det är bra. Du får gärna tycka det är bra att priserna är så höga som möjligt.Ett oligopol ger alltid högre priser än en fungerande fri marknad. Du har fel att företag alltid prissätter efter konkurrenterna. Man prissätter under konkurrenterna om TILLVERKNINGSKOSTNADEN tillåter (i en fungerande fri marknad). Som problemet är nu prissätter nVidia på samma nivå som AMD i förhållande till prestandan.För konsumenten är det BRA om priserna är låga. Förutom dig då. För dig är det bra om priset är högt…… Läs hela »

[quote name=”Martin J”]OK. Jag ger upp. Du resonerar på samma sätt som jag men drar slutsatsen att det är bra.[/quote]Jag tycker inte det är bra, det vet jag inte vart du fått det ifrån? Jag är bara realist till hur det ser ut idag och hur företag fungerar, självklart hade jag älskat lägre priser! 5 000 kronor är för dyrt för mig personligen att lägga på ett grafikkort. Det betyder inte att jag för en sekund tror att någon av aktörerna ska börja med välgörenhet och kompromissa med sina vinstmarginaler. Att tillverkningskostnaden ”tillåter” att man sätter lägre priser resulterar nästan… Läs hela »

[quote name=”Birks”]Jättebra recension gillar speciellt Surround delen i testet!En liten fundering bara, ni skriver som nackdel ”Det dyraste kortet på marknaden”Men lite snabb priskontroll så verkar det snarare som att HD7970 korten än så länge fortfarande dyrare än dessa så jag förstår inte riktigt motivationen./Danne[/quote]Priserna vi fick av våra tillverkarkontakter var faktiskt så höga som ett riktpris på 4 995 kronor, NVIDIA talade om lägre priser men då utan riktig svensk moms. Så när slutledningen författades sade våra uppgifter att priset skulle ligga närmare 5000 kronor. Just priserna är ett helsike att få rätt med de här nylanseringarna och det… Läs hela »

Jag tänkte även passa på att fråga er som läst artikeln ifall det är något ni saknar eller som ni gärna hade velat se mer av i våra grafikkortstester?

Hit us med allt ni har så ska vi se vad vi kan tillgodose, det är omstrukturering i testlabbet nu så det finns möjligheter att förändra vissa grejer. 🙂

[quote name=”-Tjalve-”][quote name=”Kinc”]Så sjukt sugen man blir på ett kraftfullt miniITX-bygge med nästa gen intel core i7 och ett GTX 680 när man läser detta. Perfekt för en 1080p-tv och Skyrim med handkontroll :-)[/quote]

Då kan man ju lika gärna köpa en xbox ju 😛

jag tyckte gott de kunde (ia alla fall försökt) göra ett PC interface denna gång, men noooo…[/quote]

Man kan köra på en xbox om man gillar bildspel och gnugga grus i ögonen 🙂

[quote name=”Kinc”]Man kan köra på en xbox om man gillar bildspel och gnugga grus i ögonen :)[/quote]

Haha talande jämförelse.. nä det finns en anledning till varför jag sålde min för 3 år sedan. 😛

[quote name=”Anton Karmehed”]Jag tänkte även passa på att fråga er som läst artikeln ifall det är något ni saknar eller som ni gärna hade velat se mer av i våra grafikkortstester? Hit us med allt ni har så ska vi se vad vi kan tillgodose, det är omstrukturering i testlabbet nu så det finns möjligheter att förändra vissa grejer. :)[/quote] I överklockningstestet hade det varit kul om ni överklockat jämförelsekorten också. Särskilt 7970. Hela grejen med GTX 680 verkar ju vara att den konstant överklockar sig själv och att det därför blir svårt att höja prestandan ytterligare med ”riktig” överklockning.… Läs hela »

Själv hoppas jag att nvidia får chansen att tjäna lite pengar på detta kort i några månader. AMD hade ju fritt spelrum till rånarpriser i början av året..Lite senare måste dock priserna ner så att vanliga dödliga har råd. Genom åren så reagerar man alltid på saker man tycker saknas i grafikkortstester, men nu när frågan kommer, så kommer man nästan inte på nått i huvetaget.Men visst… Ni får gärna ta upp hur korten hanterar Videouppspelning i monsterupplösningar och om dom klarar att accelerera Flash/html5 utan att krasha.. kan iaf vara intressant med dom lite klenare korten…En detalj som kan… Läs hela »

Nvidia verkar ha fått till ett renodlat gamer kort. Lite intressant ändå att AMD’s GCN arkitektur visar fina siffror i Compute och OpenCL testerna.

Men när det gäller spel så har Nvidia verkligen vänt på steken när gäller prestanda/strömförbrukning. Ska bli intressant att se AMD’s reaktion och om det finns fler optimeringar att hämta från båda tillverkarna.

Bäste nvidia,

Tack för att ni åtminstone ändrar prisbilden på marknaden. Jag kommer nog aldrig att köra era produkter, men ni uppfyller åtminstone en funktion.